به گزارش سلام نو، اگر نگاهی به اخبار و مقالههای پیرامون هوش مصنوعی داشته باشید، متوجه رخدادهایی شامل اشتباهات این پدیدههای مدرن میشوید. در بسیاری از رخدادهای مذکور، تغییری جزئی در الگوریتمهای یادگیری ماشین میتواند منجر به تغییرات بزرگ در عملکرد آن شود.

بهعنوان نمونهای از عملکردهای اشتباه هوش مصنوعی، میتوان آزمایش داون سانگ، استاد دانشگاه یوسی برکلی را بیان کرد که با چسباندن چند برچسب روی علامت توقف در خیابان، الگوریتم را دچار اشتباه کرد. الگوریتم مورد آزمایش، تابلوی توقف را با تابلوی حداکثر سرعت اشتباه گرفته بود. سانگ در آزمایشی دیگر از پیامهای ساختگی استفاده کرد تا یک مدل مبتنی بر متن را مجبور به ارائهی اطلاعات حساس داخلی همچون اطلاعات کارت اعتباری کاربران کند. بهعلاوه، چند ماه پیش گزارشی از هکرهای کلاه سفید منتشر شده بود که توانسته بودند با چند برچسب، اتومبیل بدون رانندهی تسلا را به جهت خلاف خیابان هدایت کنند.

در سالهای اخیر، الگوریتمهای یادگیری ماشین پیشرفتهای زیادی داشتهاند و حضور آنها در زندگی کاربران، فراگیرتر شده است. محققان با بررسی این پدیدههای پرکاربرد، نمونههای متعددی از اشتباهات آنها کشف کردهاند که از اشتباه در تشخیص تصاویر تا تشخیص سرطان را تشکیل میدهد. چنین اشتباهاتی میتواند اثراتی در بازهی بیخطر تا مرگبار داشته باشد. البته با وجود خطر چنین اشتباهاتی، عموما شناخت کمتری دربارهی آنها پیدا میکنیم و محققان نگران حل کردن این چالش عدم شناخت هستند.

مقالهای جدید از دانشمندان دانشگاه MIT، روشهایی احتمالی برای حل چالش اشتباهات هوش مصنوعی ارائه میکند. روش جدید به محققان امکان میدهد تا مدلهای قویتر یادگیری ماشین توسعه دهند که ایجاد اشکال عملکردی در آنها تقریبا غیرممکن باشد. پیش از پرداختن به روش موجود، باید مفاهیم اولیه در اشتباهات عملکردی هوش مصنوعی را درک کنیم.

قدرت اصلی فرایندهای یادگیری عمیق، از توانایی آنها در تشخیص الگو میان دادهها نشأت میگیرد. بهعنوان مثال اگر دهها هزار عکس حیوان با برچسبگذاری نام را به یک الگوریتم یادگیری ماشین بدهیم، الگوریتم میتواند الگوهای مرتبط با یک حیوان خاص، مثلا پاندا یا میمون را شناسایی کند. سپس میتواند از همین الگوها برای شناسایی حیوانات در مجموعههای جدید تصاویر استفاده کند.

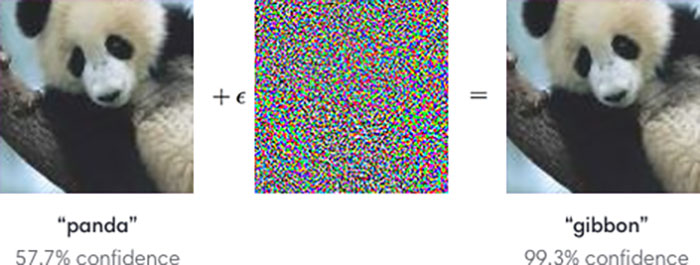

مدلهای یادگیری عمیق با وجود تواناییهای بالا، آسیبپذیری زیادی هم دارند. بهبیان دیگر، الگوریتمها تنها روی الگوهای پیکسلی تصاویر متمرکز میشوند و درک صحیحی از آنچه میبینند، ندارند. درنتیجه بهراحتی میتوان با دستکاری در الگوهای پیکسلی، سوژهی مورد مشاهدهی الگوریتم را تغییر داد. بهعنوان مثال در تصویر پایین با اضافه کردن کمی نویز به تصویر پاندا، هوش مصنوعی با درجهی اطمینان بالا آن را میمون تشخیص میدهد. در این مثال میتوان نویز را نوعی حمله به تصمیمگیری هوش مصنوعی دانست.

محققان از سالها پیش متوجه آسیبپذیری هوش مصنوعی خصوصا در بحث بینایی کامپیوتری شدهاند. البته آنها راهی برای گریز از آسیبپذیری مذکور نداشتهاند. مقالهای از محققان هوش مصنوعی، این سوال را میپرسد که آیا حملات به تصمیمگیری هوش مصنوعی اجتنابناپذیر هستند؟ مقالهی مدکور در کنفرانس تحقیقات هوش مصنوعی ICLR ارائه شد. درنهایت بهنظر میرسد صرفنظر از تعداد عکسهایی که به یک الگوریتم تزریق میشوند، همیشه راههایی خواهد بود تا الگوی تشخیصی را دچار اشتباه کنیم.

مقالهی جدید دانشگه MIT ادعا میکند که تصورات دربارهی حملات تصمیمگیری هوش مصنوعی تاکنون اشتباه بودهاند. طبق ادعای محققان، بهجای پیدا کردن روشهایی برای جمعآوری دادههای آموزشی بیشتر و ارائهی آنها به الگوریتم یادگیری عمیق، باید بهصورت بنیادی روش آموزش دادن به الگوریتم را تغییر دهیم.

برای پیشگیری از اشتباه، باید روش آموزش الگوریتم را تغییر دهیم

محققان برای نشان دادن اهمیت و تأثیر بالای اشتباهات تشخیصی الگوریتم هوش مصنوعی، مثالی ملموس را در مقاله ذکر کردهاند. در بخشی از مقاله میخوانیم که نویزهای تقریبا تصادفی و برچسبهایی که روی تابلوها نصب میشوند، به الگوهای دقیق و منحصر بهفرد الگوریتم آسیب میرسانند. الگوهایی که هر کدام برای تشخیص یک سوژهی خاص شکل گرفتهاند. بهبیان سادهتر، وقتی ماشین در تصویر پاندا میمون میبیند، رفتار غلطی انجام نداده است. درواقع الگوریتم مورد نظر، الگویی از پیکسلها (که از دید انسان مخفی هستند) را میبیند که قبلا و در فرایند یادگیری، بیشتر در تصویر میمون دیده بود.

برای درک بهتر اشتباهات الگوریتم هوش مصنوعی، یک آزمایش انجام شد. محققان از مجموعهای تصویر سگ استفاده کردند که تغییرات کوچکی در آنها داده شده بود. همین تغییرات باعث میشد تا الگوریتمهای مرسوم، تصاویر را بهعنوان تصویر گربه ببینند. سپس تصویرهای دستکاریشده با برچسب گربه به الگوریتم تازه تزریق شدند. درنهایت تصاویر جدیدی از گربههای واقعی به الگوریتم نمایش داده شد. الگوریتم جدید همهی تصاویر گربه را بهخوبی شناسایی کرد.

محققان با تکیه بر مثال بالا، نتیجه گرفتند که در هر مجموعهی داده، دو نوع الگو دیده میشود: الگوهایی که با معنای داده ارتباط دارند، مانند سبیل گربه در تصویر گربه یا موهای پاندا و الگوهایی که در دادههای تمرینی وجود دارند، اما لزوما در زمینههای دیگر صادق نیستند. نوع دوم الگوها منجر به اشتباه در هوش مصنوعی میشوند و همان ابزارهای مورد استفاده برای حمله به تصمیمگیری هستند.

باتوجهبه یافتههای بالا به این نتیجه میرسیم که اگر بخواهیم ریسک تصمیمگیری هوش مصنوعی را کاهش دهیم، باید روش آموزش به مدلهای یادگیری عمیق تغییر کند. درحالحاضر، دانشمندان هوش مصنوعی به شبکهی عصبی اجازه میدهند که هرنوع ارتباط مورد نظر خودش را برای تشخیص تصاویر استفاده کند. درنتیجه هیچ کنترلی روی ارتباط تصاویر و الگوی ایجادشده بر اثر آن ندارند. درمقابل اگر بتوان به مدل آموزش داد که تنها فاکتورهای مرتبط واقعی (که بهمعنای تصویر نزدیک هستند) را بهعنوان الگو انتخاب کند، تاحدودی موفق خواهیم بود.

محققان با تکیه بر نتیجهگیریهای قبلی، آزمایشی شامل آموزش ازطریق ارتباطات واقعی را روی الگوریتم یادگیری عمیق پیاده کردند. روش جدید، آسیبپذیری مدل را کاهش داد و تنها در ۵۰ درصد مواقع، محققان توانستند آن را دچار اشتباه کنند. شایان ذکر است مدلهای دیگر تا ۹۵ درصد احتمال خطا داشتند. بههرحال اشتباهات تشخیصی هنوز در الگوریتمهای هوش مصنوعی وجود دارند و ما تنها میتوانیم آنها را بهمرور کاهش دهیم تا شاید زمانی به صفر برسند./زومیت